En tant qu’enseignant, utiliser l’IA dans ses pratiques professionnelles nécessite d’en comprendre les grands principes de fonctionnement afin d’en faire un usage éclairé au service de la pédagogie et de la réussite de tous les élèves. Dans cet article de vulgarisation, nous vous proposons d’explorer une base de connaissance vous permettant de comprendre l’essentiel des mécanismes mis en œuvre par une IA générative lors du processus de création d’un texte à partir d’un prompt.

Qu’est-ce qu’un grand modèle de langage ?

Schéma de la modélisation d’un neurone artificiel (perceptron).

Un neurone artificiel effectue la somme pondérée de toutes les entrées affectées d’un coefficient appelé poids. La fonction d’activation renvoie 1 si cette somme est supérieure ou égale à 1 et 0 sinon.

Schéma d’un réseau de neurones artificiels.

Celui-ci est constitué d’une couche d’entrée, de plusieurs couches cachées et d’une couche de sortie. Chaque neurone d’une couche est relié à tous les neurones de la couche suivante.

En premier lieu, les autorégressifs, tels que GPT (Generative Pre-trained Transformer) qui prédisent statistiquement le mot suivant en s’appuyant sur ceux qui les précèdent, ce qui les rend particulièrement bien adaptés à la génération de texte.

En second lieu, on trouve les modèles dits bidirectionnels, comme BERT (Bidirectional Encoder Representations from Transformers) qui analysent la phrase entière, de gauche à droite et réciproquement, afin de compléter les “trous”.

Dans le cadre de la génération créative de textes, nous nous intéresserons par la suite aux modèles autorégressifs.

Voici quelques-uns des grands modèles de langage les plus performants au moment d’écrire cet article :

- LLAMA3 (Meta ; Etats-Unis)

- CLAUDE 3 (Anthropic ; Etats-Unis)

- GPT-4 (Open AI ; Etats-Unis) ;

- BARD (Google ; Etats-Unis)

- MISTRAL Large (Mistral AI ; France)

Un token (jeton en français) est une unité de base utilisée dans le traitement automatique du langage naturel (TALN) pour modéliser un texte. Il peut être une ponctuation, un mot ou une sous-unité plus petite comme un morphème [2]. Chaque token est repéré par un identifiant (Id) unique propre à chaque LLM.

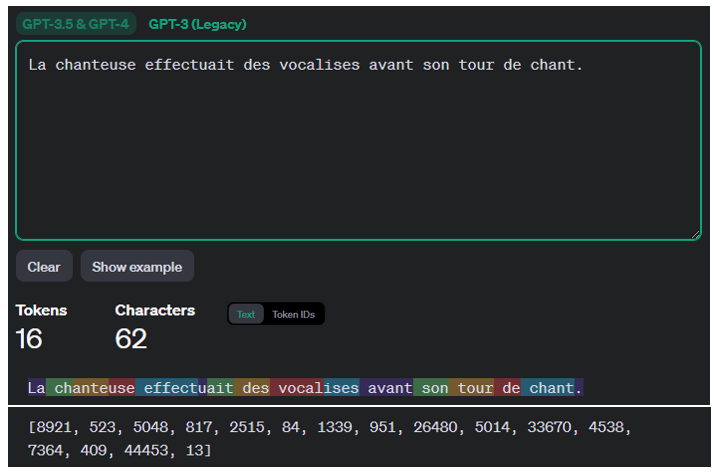

Regardons d’un peu plus près le principe de fonctionnement du tokenizer d’OpenAI en lui entrant la phrase : "La chanteuse effectuait des vocalises avant son tour de chant."

Illustration du principe fonctionnement du tokeniser d’OpenAI à partir de la phrase "La chanteuse effectuait des vocalises avant son tour de chant".

Cette phrase comportant 10 mots pour un total de 62 caractères est composée de 16 tokens.

Chacun d’entre eux possède un "Id" unique. Par exemple 8921 pour le token "La"

On remarque que les 10 mots qui composent la phrase font intervenir 16 tokens ayant chacun un "Id" unique.

Les tokens permettent de découper le texte en unités significatives pour l’analyse linguistique facilitant ainsi le traitement par les modèles d’IA génératives. Ils permettent par exemple de comprendre et générer de nombreux mots et leurs variations à partir d’un vocabulaire de base limité. Lors de la phase d’apprentissage, les grands modèles de langage apprennent à comprendre les relations statistiques entre les tokens . Cela leur permet ensuite de générer des séries de tokens liés les uns aux autres selon des lois mathématiques précises.

Une règle empirique, permettant d’avoir un ordre de grandeur en tête, est qu’un token correspond généralement à environ 4 caractères pour un texte en anglais courant. Cela se traduit par le fait qu’un token vaut environ ¾ de mot (100 tokens ≈ 75 mots). La manière dont les mots sont divisés en tokens dépend bien évidemment de la langue.

Le nombre de tokens qu’un grand modèle de langage peut traiter en entrée et en sortie est limité et dépend de l’architecture et de la taille du réseau profond de neurones employé. Par exemple pour la version gratuite de ChatGPT 3.5, le nombre de tokens maximum pouvant être traité est de 4096 ce qui correspond à environ 3000 mots. Cette limitation explique pourquoi l’IA stoppe sa réponse dès que la somme des tokens d’entrée et de sortie dépasse 4096. Afin d’optimiser un prompt il convient donc d’être concis dans sa formulation ou bien fractionner les tâches à faire réaliser par l’IA en plusieurs fois. Dans les versions payantes d’IA génératives, le nombre de tokens consommé en entrée et en sortie sert d’unité de mesure pour le prix facturé.

Pour le LLM ChatGPT-4 (payant)

Nombre de paramètres sur le lequel le LLM a été entraîné : 100000 milliards.

Volume de texte pris en compte : 25000 mots.

Combien de mots précédents peut-il analyser ? : environ 6000 mots (8192 tokens).

Nombre de langues supportées : 26.

Accepte des images en entrée ? : Oui.

Analyse les fichiers PDF ? : Oui.

Pour le LLM ChatGPT-3 (gratuit)

Nombre de paramètres sur le lequel le LLM a été entraîné : 175 milliards.

Volume de texte pris en compte : 3000 mots.

Combien de mots précédents peut-il analyser ? : environ 3000 mots (4096 tokens).

Nombre de langues supportées : 25.

Accepte des images en entrée ? : Non.

Analyse les fichiers PDF ? : Non.

La tokenization permet, en particulier, de gérer les situations pouvant conduire potentiellement à des points de blocages. Cela est le cas, par exemple, lorsque certains mots de la requête ne sont pas présents dans le vocabulaire de base du modèle issu de la phase d’apprentissage. Cette opération, permet de s’affranchir de ce problème via l’analyse sémantique des tokens constitutifs d’un mot inconnu ne figurant pas initialement dans les données d’entraînement du LLM, afin que l’IA puisse néanmoins en saisir le sens.

Réciproquement, la recomposition en sortie des tokens associés entre eux selon des lois probabilistes offre à l’IA la possibilité de former de nouveaux mots ne figurant pas initialement dans sa base de vocabulaire. Ce mécanisme permet une certaine créativité de la part de l’IA, donnant l’illusion de converser avec un être humain.

Contrairement aux algorithmes classiques qualifiés de déterministes [3], les grands modèles de langage qui s’appuient sur des réseaux de neurones profonds sont probabilistes. D’une manière simplifiée, en analysant les tokens qui précèdent dans un texte, ils tentent de prédire quel est le token qui a le plus de chance d’être le suivant. Cette spécificité, propice à la créativité, peut conduire, en revanche, à des réponses fausses ou complètement absurdes de leur part : on parle alors d’hallucinations de l’IA. C’est par exemple le cas si une IA générative vous propose une phrase comme "La souris mange le chat". Il est peu probable qu’un LLM génère cette phrase mais cela est néanmoins statistiquement possible.

Afin d’illustrer concrètement cela, allons sur la plateforme IA générative de textes de Vittascience et demandons au "VittaBot" la suite de la phrase "Marly-le-Roi est ...".

Moi : Marly-le-Roi est ...

VittaBot : Marly-le-Roi est une ville située dans le département des Yvelines, en région Ile-de-France. Elle se trouve à l’ouest de Paris et compte environ 16000 habitants. Marly-le-Roi est réputée pour son château, qui a été le résidence de nombreux rois de France, notamment Louis XIV. Aujourd’hui, le château est ouvert au public et accueille des expositions et des évènements culturels. La ville est également entourée de nombreux espaces verts.

Par défaut, l’interface montre la couleur de fond derrière chacun des tokens : celle-ci donne un indice sur leur probabilité respective. Le vert signale une forte probabilité alors que le rouge une faible. En cliquant sur un token on peut accéder à sa probabilité. Plusieurs d’entre eux ont une probabilité de 100 % : Ile-de-France, Yvelines... Avec une valeur de température de 0,5 (50 %), le modèle de LLM Mixtral de la startup française Mistral AI, fournit des tokens dont la couleur de fond dominante est verte. Pour des valeurs plus élevées de la température, on trouve de plus en plus de tokens sur fond rouge.

En résumé, retenons que le paramètre appelé température détermine à quel point le modèle LLM sera plus ou moins créatif au niveau des réponses qu’il fournira. Le LLM, à partir d’une série de tokens, va choisir le suivant en analysant les probabilités distribuées à travers tous les tokens qui composent le vocabulaire du modèle. Un paramètre de température élevé (de 0,7 à 1) permet au modèle LLM de produire des résultats plus aléatoires donc plus créatifs mais avec un risque d’hallucination accru. Un paramètre de température plus bas (0 à 0,3) fournira, quant à lui, des réponses plus prévisibles et cohérentes.

Lors de l’utilisation d’une IA générative, il est donc important de trouver le bon équilibre entre créativité et précision en fonction des besoins spécifiques recherchés.

Comment une IA générative interprète-t-elle les mots ?

Lorsque l’on rédige un SMS, après chaque mot, deux ou trois mots sont proposés par le smartphone afin de compléter plus rapidement le message que vous souhaitez envoyer. Par exemple, quand vous tapez « Bonjour, comment », le smartphone peut vous suggérer les propositions « allez-vous », « vas-tu », « ça », comme mots suivants.

En supposant que vous sélectionnez à chaque fois les mots suggérés par votre smartphone, vous vous rendrez très vite compte que le message formé n’a soit pas de sens, soit est très éloigné de celui que vous souhaitiez initialement transmettre. En analysant un ensemble de trois ou quatre mots consécutifs, cela peut avoir un sens, mais généralement les mots proposés ne s’assemblent pas en quelque chose de significatif dans le cadre du contexte du message. Cela s’explique par le fait que le modèle utilisé par l’application SMS du smartphone ne prend pas en compte le contexte global du message : il se contente de prédire quel mot est statistiquement le plus susceptible de venir après les derniers mots.

Afin de pallier cet inconvénient, les modèles LLM autorégressifs s’appuient sur une architecture de type Transformer afin de garder en mémoire le contexte de ce qui est écrit avec pour finalité de donner du sens au texte qu’ils vont générer.

Le smartphone peut suggérer le mot suivant à utiliser dans un message de type SMS, mais n’a pas la capacité de générer un texte cohérent car il ne tient pas compte du contexte global.

En particulier, cette représentation mathématique permet de rendre compte de la polysémie de certains mots liée au contexte dans lequel on les rencontre. Ainsi, par exemple le mot « bouchon » peut désigner à la fois l’objet permettant d’obturer une bouteille ou un blocage de la circulation routière. Dans ce cas de figure le mot « bouchon » sera représenté par deux vecteurs différents permettant à l’IA de saisir la nuance de sens en fonction du contexte.

Schéma illustrant la différence de sens du mot "bouchon" en fonction du contexte.

À chaque sens d’un mot est associé un vecteur particulier.

La vectorisation des mots s’appuie sur la sémantique distributionnelle dont l’objet est d’étudier statistiquement comment les mots sont utilisés et apparaissent à proximité les uns des autres dans un corpus de texte. Selon ce principe, les mots qui apparaissent dans des contextes similaires ont tendance à avoir des significations proches ou à être liés sémantiquement : c’est l’hypothèse distributionnelle (distributional hypothesis).

Des mots sémantiquement similaires seront représentés par des vecteurs proches les uns des autres dans un espace vectoriel [4]

La vectorisation permet de capturer des relations sémantiques complexes dans l’espace vectoriel, en utilisant des opérations algébriques simples, telles que des additions et des soustractions, sur les vecteurs de mots. Par exemple si on demande à une IA générative d’indiquer le résultat de roi + (homme - femme) la réponse fournie sera le mot reine. Cela est assez facile à comprendre lorsque l’on réalise les constructions géométriques sur les vecteurs associés aux mots précédents. Remarquons en particulier que la soustraction vectorielle homme - femme permet d’extraire la différence sémantique entre ces deux mots à savoir le genre.

Schéma du principe de la vectorisation des mots

Chaque mot peut être représenté par un vecteur.

On peut réaliser des additions ou des soustractions entre des vecteurs mots.

Les « vecteurs mots » utilisés dans cet article sont extrêmement simplifiés car ils sont représentés dans des espaces vectoriels à 2 ou 3 dimensions. En réalité, les modèles de word embedding modélisent les mots dans des espaces vectoriels comportant beaucoup plus de dimensions afin de mieux pouvoir en saisir les nuances en fonction du contexte.

- la tokenization : l’entrée textuelle est transformée en une série de tokens ;

- l’ embedding ou vectorisation : les tokens sont transformés en vecteurs numériques, qui représentent les entités sémantiques et les relations entre eux dans un espace multidimensionnel ;

- l’encodage positionnel : un indice positionnel est ajouté aux vecteurs pour tenir compte de l’ordre des tokens et de leur position relative dans la séquence.

Le pré-traitement de la méthode "Transformer" s’appuie sur trois méthodes qui sont dans l’ordre : la tokenization (découpage en jetons), l’embedding (vectorisation) et le positionnal encoding (encodage positionnel).

Après les trois étapes préalables précédentes, le modèle Transformer crée une série de blocs empilés les uns sur les autres, chacun d’entre eux étant constitué de deux parties principales :

- un mécanisme d’attention : il permet de repérer les relations entre les différents tokens, en tenant compte du contexte ;

- un réseau de neurones feedforward : il s’agit d’un réseau de neurones traditionnel qui traite les informations et effectue des prédictions.

Enfin, la dernière étape consiste en une couche de neurones de sortie Softmax qui transforme les scores donnés par le Transformer en probabilités afin de choisir le meilleur mot suivant dans le texte généré par l’IA en tenant compte du contexte.

Schématisation simplifié de l’architecture "Transformer".

Le prompt subit préalablement un pré-traitement en 3 parties : tokenization (découpage en jetons), embedding (vectorisation des jetons) et enfin positionnal encoding (encodage positionnel des jetons). Des blocs empilés composés de deux parties (attention et feedforward) alimentent un réseau de neurones appelé softmax fournissant en sortie un texte cohérent tenat compte du contexte du prompt.

Les IA génératives sont-elles dotées d’intelligence ou pas ?

Communément, l’intelligence est associée à la capacité de comprendre, d’apprendre, de raisonner, de résoudre des problèmes et d’adapter ses actions à des situations nouvelles et complexes.

Laissons le soin, dans ce qui suit, à ChatGPT-3.5 d’argumenter lui-même pourquoi on peut considérer qu’un grand modèle de langage (LLM) est doté d’intelligence. Pour cela posons-lui la question via le prompt suivant :

- Agis en tant qu’expert en intelligence artificielle.

- Je suis rédacteur d’un blog de vulgarisation sur l’IA.

- Peux-tu répondre à cette question d’une manière argumentée : "Est-ce-qu’un LLM fait preuve d’intelligence ou s’agit-il uniquement d’un algorithme ?

Extrait de la réponse de ChatGPT-3.5 :

Les LLM mobilisent trois compétences révélatrices d’une forme d’intelligence.

1. Capacité à comprendre et à générer du texte :

Les LLM sont capables de comprendre et de générer du texte de manière cohérente et contextuellement appropriée. Ils peuvent répondre à des questions, rédiger des articles, des poèmes, des paroles de chansons et même du code informatique. Cette capacité à interagir avec le langage de manière fluide et naturelle est souvent perçue comme une manifestation de l’intelligence.

2. Capacité à apprendre à partir de grandes quantités de données :

Les LLM sont généralement pré-entraînés sur de vastes ensembles de données textuelles, ce qui leur permet d’acquérir des connaissances sur divers sujets et styles linguistiques. Ils peuvent utiliser ces connaissances pour répondre à des questions ou générer du texte dans des domaines où ils n’ont pas été explicitement programmés. Cette capacité à apprendre de manière autonome à partir des données est une caractéristique essentielle de l’intelligence.

3. Adaptabilité et généralisation :

Les LLM peuvent également être capables de généraliser à partir de ce qu’ils ont appris pour aborder de nouveaux domaines ou tâches. Par exemple, un LLM entraîné sur des articles scientifiques pourrait être en mesure de répondre à des questions sur des sujets qu’il n’a pas spécifiquement rencontrés lors de son entraînement. Cette capacité à appliquer des connaissances préalables à de nouvelles situations est une caractéristique clé de l’intelligence humaine.

Quand quelque chose ou quelqu’un est capable de parler, on lui attribue généralement de l’intelligence, mais c’est une erreur. On peut manipuler la langue sans penser, sans être intelligent. Et c’est un peu le problème de ces systèmes : ils sont très volubiles, très fluides, très corrects grammaticalement, mais ce qu’ils racontent n’est pas toujours vrai.

Yann Le Cun

Ainsi, selon Yann le Cun, les modèles de LLM s’appuyant sur une prédiction autorégressive peuvent difficilement être qualifiés d’intelligent principalement pour deux raisons :

1. La réponse générée par l’IA n’est pas planifiée

La machine n’a pas réfléchi à l’avance à ce qu’elle allait dire car elle produit un mot après l’autre de manière autorégressive.

Yann Le Cun

2. L’IA n’a pas conscience du monde et n’a pas de compréhension de la réalité sous-jacente

Ces systèmes compensent leur faiblesse de raisonnement par l’accumulation de connaissances tirées de tous les textes possibles d’internet (…). Mais leur connaissance du monde, du monde physique en particulier, est extrêmement réduite : ils n’ont aucune notion de l’existence de la réalité car ils sont purement entraînés sur des textes. Or la grande majorité de l’intelligence humaine est non linguistique car elle s’appuie sur notre expérience du monde réel ; un sens commun que n’ont pas les machines.

Yann Le Cun

En résumé, les grands modèles de langage (LLM) ne font que manipuler des statistiques et des modèles probabilistes : ils n’ont pas de véritable compréhension ou conscience de ce qu’ils génèrent. Ils fonctionnent sur la base de modèles mathématiques et de calculs informatiques sans avoir de conscience de soi ou de perception de leur environnement.

Ainsi, selon ce point de vue, les LLM seraient simplement des algorithmes sophistiqués traitant des données d’entrée pour produire des résultats, sans véritable « intelligence » au sens traditionnel du terme.

La question de savoir si un grand modèle de langage (LLM) fait preuve d’intelligence ou s’il s’agit simplement d’un algorithme dépend fondamentalement de la définition de l’intelligence que l’on choisit d’adopter.

Si l’on considère que l’intelligence consiste essentiellement en la capacité de traiter l’information de manière complexe et de produire des résultats utiles, alors les LLM peuvent être considérés comme faisant preuve d’une certaine forme d’intelligence.

En revanche, si l’on définit l’intelligence en termes de conscience de soi et du monde, de compréhension profonde et de capacité à prendre des décisions morales, alors les LLM ne répondent pas à ces critères et demeurent seulement des outils algorithmiques avancés.

Il est fort à parier que l’évolution des technologies dans les prochaines années et les progrès qui en découleront nous amèneront à nous questionner à nouveau d’une manière encore plus aigüe sur la forme d’intelligence dont pourraient faire preuve les LLM. Pour le moment, les capacités émergentes des LLM (savoir traduire, résumer, créer, calculer, raisonner, etc.) sont très loin ne serait-ce que d’égaler l’intelligence humaine, mais elles en revêtent déjà quelques uns des attributs.

À vous de juger !

Cela peut aussi vous intéresser

Intelligence artificielle : évolution ou révolution ?

IA générative : l’art du prompt

Comment intégrer l’IA générative dans sa pédagogie ?